NEU

Artist Interview: Bill Evans

Es ist ein offenes Geheimnis, dass Gesangs-Aufnahmen im Studio bei der Postproduktion bearbeitet und „falsche“ Töne gegebenenfalls korrigiert werden. Der Begriff Autotune hat sich nicht umsonst spätestens seit 1998 nach Cher’s Hit-Single Believe im musikalischen Sprachgebrauch etabliert – dieser Klangeffekt wurde dort bewusst überzogen und erlangte durch den kommerziellen Erfolg des Songs große Bekanntheit. Auch Instrumentals lassen sich bei Spielfehlern im Tonstudio theoretisch beliebig oft neu aufnehmen und nachbearbeiten.

Dieser Drang zur Perfektion hat nicht wenig mit den ästhetischen Erwartungen der Hörerschaft zu tun.

Es stellt sich jedoch die Frage, wie authentisch die musikalische Performance noch ist, wenn jeder vermeintliche Fehler in einer Melodie oder einem Akkord wegretuschiert wird? Inwieweit geht dabei letztendlich die „Magie des Moments“ verloren?

Genau dieser Problematik stellt sich Bill Evans. Seit Jahren ist er darauf spezialisiert, die technischen Spielfehler von virtuosen Musikern in Live-Performances (sowohl On-Stage als auch im Studio) ohne Authentizitätsverlust zu bearbeiten. Zu seinem Portfolio gehören Legenden wie Steve Lukather (Toto), Steve Morse (Deep Purple), Steve Vai (Frank Zappa) und Mike Portnoy (Dream Theater).

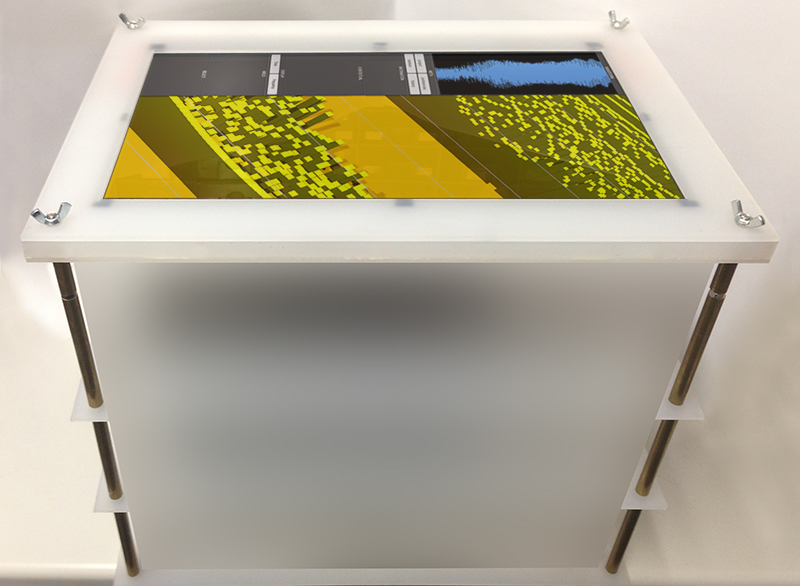

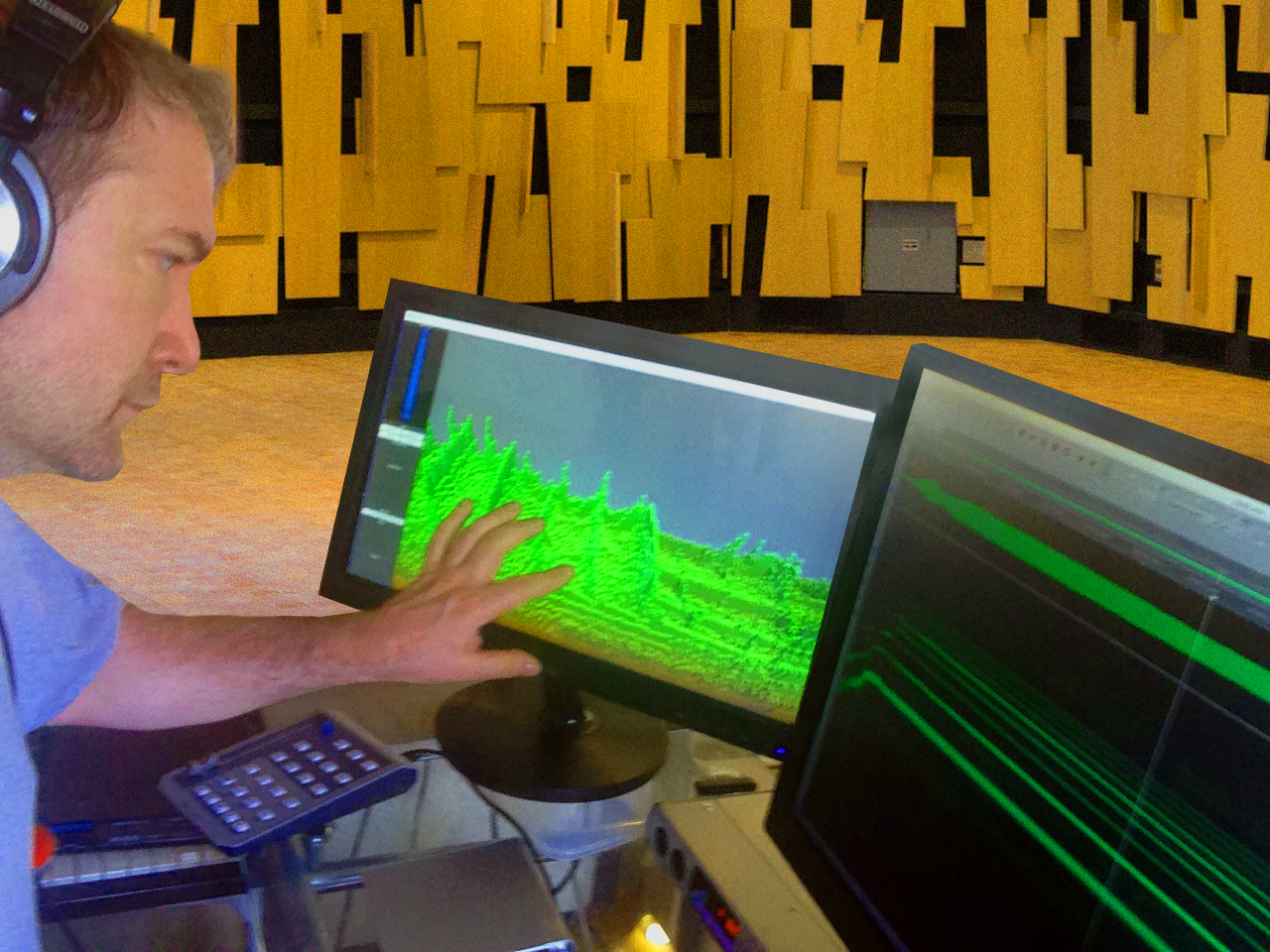

Als Resultat seiner intensiven Recherchen und Erfahrungen mit diesem speziellen Bereich der Postproduktion, hat er eine Doktorarbeit an der Manchester Metropolitan University publiziert. Seine Methode nennt er Harmonic Phrase Analysis and Restoration, kurz HPAR. Zu seinen Werkzeugen gehören modernste und zum Teil eigens entwickelte Technologien, die recht futuristisch daherkommen. Neben SpectraLayers Pro nutzt er Bexeles, eine Virtual Audio Workstation (VAW),

die er selbst konstruiert hat. Diese lässt sich über Eye/Head-Tracking sowie ein volumetrisch haptisches Display (VHD) bedienen. Das Display projiziert dabei ein dreidimensionales haptisches Sensorfeld in den Raum: Wenn Evans dort hineingreift, kann er den Klang direkt mit den Händen wie Lehm formen.

Bill Evans gibt uns im Interview tiefgreifende Einblicke in seine Arbeit mit Musiktechnologien der nächsten Generation, seine HPAR-Methode und erklärt, wie SpectraLayers das Audio-Editing revolutioniert hat.

Bill Evans – „Begrifflichkeiten wie ‚Fehler‘ und ‚Fix‘ sind sehr aufgeladen“

Du hast einen PhD für die Entwicklung eines technologischen und musikalischen Ansatzes bekommen (Harmonic Phrase Analysis and Restoration; HPAR), der Fehler ohne Authentizitätsverlust in Live-Performances korrigiert. Wie entstand das Interesse sich speziell mit dieser Nische auseinander zu setzen?

Meine Herangehensweise beginnt mit der erneuten Bestandsaufnahme, was ein Fehler in einem Recording ist und was es bedeuten würde ihn zu fixen. Begrifflichkeiten wie „Fehler“ und „Fix“ sind sehr aufgeladen. Egal welche Bedeutung wir ihnen zuschreiben, sie haben einen Einfluss, der weiter über das hinaus geht, wie mit ihnen im Studio umgegangen wird. Die Musikindustrie definiert „Fehler“ als eine Instanz, in der der Zuhörer bewusst wahrnimmt, dass der Output des Performers inkorrekt ist und somit auch „gefixt“ werden kann. Aber ist das, was Musik wirklich ausmacht?

Wenn das Einfangen einer tollen Performance unser Ziel ist, könnten wir dann nicht auch einen Fehler als einen nicht zur Intention des Künstlers passenden Sound definieren? Die Antwort sollte nicht sein: „Hat jemand gemerkt, dass ich es vermasselt habe?“ Eine musikalischere Variante wäre: „Das ist nicht, was ich in meinem Kopf hatte, das ist nicht was ich sagen wollte und wie es hätte klingen sollen.“

Sobald du Performances als solche definierst, kannst du dein Ziel vom Verstecken von Fehlern hin zur Restauration der ursprünglichen Intention der Performance ändern. Das ist das Ziel meiner Technik. Voraussagen, was der Künstler zu spielen gedachte und wie es klingten sollte. Der Prozess ist ein bisschen wie Archäologie, gemixt mit forensischer Wissenschaft und Old-Fashion Detektivarbeit.

Der Prozess ist nicht perfekt und verlangt kontinuierlichen Feinschliff. Dieser bildet sich aus verschiedenen Gebieten wie Musiktheorie, Kognitions-

wissenschaften, Psychoakustik, Signalverarbeitung und das Repertoire des Künstlers. Es wird davon gezeichnet wie Menschen die musikalischen und physischen Aspekte der Performance planen. Wenn der Prozess fehlschlägt, bleiben Hinweise der originalen Intention übrig. Gepaart mit der Untersuchung wie Zuhörer Klang und Musik wahrnehmen sowie den gängigen Aspekten einer Peformance (z.B. Phrasierung), kann dann ein Bild der beabsichtigten Performance entstehen.

Kannst du kurz erläutern, wie dein HPAR-Prinzip funktioniert und was hat es mit „Belexes“, der eigens von dir entwickelten virtuellen Audio Workstation (VAW), auf sich?

Belexes ist ein neuer Typ der Hardware/Software Audio Workstation, die designt wurde, um ein neues Audio-Editing-Paradigma zu definieren: Direktes, manuelles Bearbeiten von Klängen. Aktuelle Audio-Editoren geben uns viele Möglichkeiten Sound zu visualisieren. Belexes fragt folgendes: „Was ist, wenn du statt durch das Computerprogramm zu gehen, Klang mit deinen Händen wie Ton formen könntest?“

Bexeles beantwortet diese Frage mit einem völlig anderen Ansatz wie mit Audio umzugehen ist. Es ist das erste weltweite 3D-Audio-Editing-System, welches mit 3D-Objekten interagiert. Alle Operationen werden mit 3D Multitouch-Aktionen durchgeführt. Manche sind wie auf herkömmlichen Touchscreens und manche mitten in der Luft. Um Haptik zu simulieren, habe ich das erste Voxel-addressierte Kraftfeld-Projektionssystem entwickelt: der volumetrische haptische Display (VHD). In Kombination mit Eye- und Headtracking, erlebt der Engineer den Klang als komplett responsives 3D-Objekt – welches ohne zusätzliche lästige Peripherie wie VR-Brillen, Handschuhe oder Marker auskommt.

Der Name „Bexeles“ kommt von einem Kansas Song von Kerry Livgren. Kerry kommt immer auf tolle Namensideen. Und Bexeles ist ein Charakter eines Songs, Kerry hat mir das erzählt.

Siehst du deine Arbeit als eine eigene Kunstform oder eher als eine rein technische Optimierung an? Und wie lebst du dich außerhalb des Studios kreativ aus?

Ein bisschen von beidem, wie die musikalische Performance selbst auch. Manchmal wünschte ich mir, es wäre noch mehr technischer Natur. Ich kann den Prozess am besten wie folgt beschreiben: handele wie ein Engineer und denke wie ein Musiker.

Zur zweiten Frage: Gibt es überhaupt ein „außerhalb“?

SpectraLayers Pro – „SpectraLayers ist eines dieser Applikationen, die die Trennlinie zwischen Technologie und Magie verschwimmen lässt“

Wieso hast du dich für SpectraLayers Pro 4 entschieden und was macht das Programm aus deiner Sicht so einzigartig?

Ich habe das Gefühl, dass SpectraLayers eher mich ausgesucht hat! Es gibt nichts anderes, dass überhaupt versucht das zu können, was SpectraLayers kann. Es ist wie Photoshop für Audio. Die Arbeit, die Tom und ich mit der Harmonic Phrase Analysis und Performance Restauration machen, wäre ohne SpectraLayers schlichtweg ummöglich. So wie das meiste digitale Foto-Editing ohne Photoshop nicht machbar wäre.

Ich möchte damit nicht suggerieren, dass du Audiowissenschaften studieren musst, um SpectraLayers zu nutzen. Wie bei Photoshop gibt es eine Vielzahl an Möglichkeiten, um das Programm zu nutzen – und das auf jedem Expertise-Level.

Momentan wird die meiste Audio-Bearbeitung mit Waveformen gemacht. Das war revolutionär als es 1970 eingeführt wurde. Was Robin Lobel mit der Erfindung von SpectraLayers erreicht hat, war die nächste Revolution in Sachen Audiovisualisierung und Editing. Er hat nicht mal Spektogramme erfunden – er hat sie aber visuell nützlicher gestaltet. Weil er das Programm auf ein Skill-Set basieren ließ und viele schon Photoshop genutzt haben, sind die Tools quasi selbsterklärend.

SpectraLayers ist eines dieser Applikationen, die die Trennlinie zwischen Technologie und Magie verschwimmen lässt. Auf der Wettbewerbsebene, erlaubt es mir Dinge zu machen, die andere Engineers nicht können – vor allem bei der Arbeit mit virtuosen Künstlern, wo jedes Detail entscheidend ist.

Auf welche Funktion in SpectraLayers Pro 4 greifst du am häufigsten zurück?

Ich mag es wirklich sehr in die Audiodatei hineinzutauchen, um die Musik aufzudecken, die sich vielleicht noch darin versteckt. Das erste was SpectraLayers macht, ist aufzuzeigen, wo das Potential liegt, um den Sound noch klarer und organischer zu machen. Ebenso zeigt es, wo der Aufnahmeprozess vielleicht Dinge verschleiert hat und welche Parts Emotionen hervorbringen.

Dies bedeutet also manchmal die Harmonic-Tools zu nutzen, um spezifische Harmonien zu isolieren. Das Harmonic Series Tool kann eine ganze Serie examinieren. Mit dem Multiple Track-Feature, kann ich selektiv Audio-Sektionen entfernen und Anhören, was übrig bleibt. Oder einfach nur die Auswahl anhören.

Das Eraser bzw. Dodge Tool ist bemerkenswert, vor allem weil (wie in Photoshop) du die Kantenschärfe und Deckkraft einstellen kannst. Nur mit diesen zwei Tools, kannst du unglaubliche Dinge machen. Sie erlauben es mir präzise Soundelemente hervorzubringen oder zu verschleiern.

Das Clone Tool ist fantastisch, um Soundparts zu kopieren. Oft höre ich etwas in einem Soundabschnitt, den ich auf eine andere Stelle anwenden möchte – und mit dem Tool habe ich diese Möglichkeit.

Und dann gibt es da noch ein Feature in der nächsten Version von SpectraLayers, über das ich nicht reden darf. Alles was ich sagen kann ist, dass es das revolutioniert, was mit einem Spektrogramm gesehen werden kann. Um etwas zu fixen, musst du nämlich in erster Linie in der Lage sein, es zu sehen!

Du tauschst dich öfters mit dem Entwickler von SpectraLayers Pro, Robin Lobel aus. Worüber fachsimpelt ihr?

Komischerweise reden wir oft über Donuts! Es ist ein Thema, über das die Leute sich nicht mehr unterhalten. Was für eine Schande. Sie sind köstlich.

Mit dem Schöpfer deines Lieblingstools zu reden, ist wie mit deinem Lieblingskünstler zu sprechen. Wenn wir fachsimpeln, hilft Robin mir bei dem Verständnis seiner tiefgründigen Ideen des Programms, welche ich dann nutzen kann, um neue Techniken und Prozesse zu gestalten. Andererseits teile ich diese Techniken mit ihm, die ihm wiederum Inspiration für das SpectraLayers Feature-Set geben.

Ich mag es auch ihn zu fragen, wie ich bestimmte Sachen mit dem Programm machen kann, da ich Handbücher aktiv meide. Er antwortet mir dann immer, indem er mir das Handbuch zuschickt.

Performance-Restauration – „Alle gängigen Methoden ‚Fehler zu fixen‘ nehmen das weg, was die Performance in erster Linie großartig gemacht hat“

Mixing und Mastering ist vielen eher ein Begriff als der Bereich der Audio/Performance-Restauration oder Fehler-Analyse. Wie würdest du jemandem erklären, der sich mit dieser Materie nicht auskennt, was du genau machst und wieso diese Expertise essentiel für das Hörerlebnis ist?

Im Kern glaube ich, dass großartige Musik aus großartiger Performance entsteht. Bevor Mixing und Mastering überhaupt ins Spiel kommen, brauchst du diese Performance auf der Aufnahme. Jedoch haben die modernen kulturellen und industriellen Erwartungen in Bezug auf technische Perfektion, die Musiker weit weg von dieser Art der Performance gebracht. Diese entwickeln sich zu sichereren, weniger ausdrucksstarken und emotionsloseren Performances – kurz gesagt, weniger authentisch.

Egal ob bei einem Demi Lovato Konzert oder beim Hören eines Periphery Albums, erwarten die Zuschauer einen „perfekten“ Auftritt. Eine flach gesungene Phrase, vergessener Text, versehentlicher Schlag auf die Gitarren-Tonabnehmer oder verpatzte Gitarren-Noten – das sind Zeichen eines Amateurs. Nichtsdestotrotz sind aus vielerlei Gründen, selbst vorbereitete und die geübtesten Musiker gegenüber dieser Art von Fehlern nicht immun – vor allem bei der Aufnahme einer Live-Performance.

Das Problem hierbei besteht darin, dass alle gängigen Methoden diese „Fehler“ zu „fixen“, das wegnehmen, was die Performance in erster Linie großartig gemacht hat: der kontinuierliche, unbearbeitete und lineare Flow von Ausdruck, der nur aus dem spezifischen Rahmen von Zeit, Ort und Denkweise entsteht.

Die gängigste Art mit „Fehlern“ umzugehen, ist die Problemstelle zu re-recorden. Du kannst aber nicht in der Zeit zurückgehen – du kannst nicht den Moment reproduzieren – also kannst du auch nicht reproduzieren, was die Performance einst war. Es ist egal, ob du Beyoncé or Buckethead bist. Das sage ich nicht, um Künstler zu kritisieren – es ist eine Notwendigkeit, keine Wahl.

Die andere bekannte Methode für Recording Engineers ist, es zu „fixen“. Das Ziel dieser Herangehensweise ist den Fehler zu verschleiern – ihn verstecken, damit er daran gehindert wird, in die Wahrnehmung der Zuhörers zu dringen. Es klingt sogar weniger authentisch als ein Re-record, weil die neuen hinzugefügten Parts niemals von einem Künstler performt wurden und somit nicht den vom Künstler beabsichtigen Ausdruck repräsentieren. Wie bei den Künstler, kritisiere ich nicht die Engineers – es muss schlichtweg mit allem umgegangen werden, was der Zuhörer als Fehler interpretieren könnte.

Das Ganze hat jedoch seinen Preis. Künstler werden dazu gezwungen weniger Möglichkeiten wahrzunehmen und dadurch weniger ausdrucksstark zu sein. Nichtsdestotrotz kommen „Fehler“ unweigerlich vor. Selbst Aretha Frankling und Steve Morse machen diese häufig. Das Resultat ist, dass die finale „Performance“ durch Re-Recording und Audio-Editing verwässert. Bevor Mixing und Mastering ansteht, steht folgende Frage im Raum: „Was bedeutet diese Aufnahme überhaupt

und was ist dessen Wert?“

Künstler sollten die Möglichkeit haben, sich frei ausdrücken zu können – ohne Angst, für Fehler verurteilt zu werden.

Welche Künstler und Musiker vertrauen auf deine Expertise in Sachen Performance-Restauration?

Ich arbeite am meisten mit „virtuosen“ Künstlern (vorrangig Gitarristen), wo Klarheit essentiell für den Zuhörer ist, um alle Details der einzigartigen Performance zu erfassen.

Selten werde ich bei einem Projekt nur Performance-Restauration betreiben. Meine Arbeit (harmonische Phrasenanalyse und Restauration) restauriert nicht nur Performances, sondern verbessert die Klangqualität sowie dessen Charakter. Mein Hauptziel als Produzent und Engineer ist es, Aufnahmen mit außergewöhnlicher Klarheit zu kreieren, vor allem Live-Aufnahmen. Dabei entdeckte ich, dass die benötigten Tools für die Behebung von Problemem, sich auch auf die Restauration anwenden lassen.

Um beides zu bewerkstelligen, müssen Aufnahmen in musikalische und klangbasierte Elemente – bis hin zu ihren kleinsten Gebilden – zerlegt werden. Sobald du das geschafft hast, kannst du Audio auf eine neue und innovative Weise rekonstituieren – immer in Bezug zu Wahrnehmung von Sound und Musik.

Wenn ein Künstler nach einer Zusammenarbeit fragt, geht es meistens darum, die Performance hervorstechen zu lassen und jegliche Form von Ungereimheiten, die es für den Zuhörer geben könnte, zu entfernen. Das alles fällt under die Rubrik der Restauration, weil die Performance bereits erfolgt ist.

Zum Beispiel bei Live-Recordings, bei denen es viel störende Geräusche gibt. Oder Studio-Aufnahmen, wo der musikalische Aspekt weiter im Vordergrund stand als der Technische. Du hast vielleicht eine tolle Performance abgeliefert, aber mittendrin wurde das Gitarren-Mikrofon umgestoßen, sodass es Richtung Publikum den Klang aufnimmt. Oder du willst einfach einen Mix, der das Maximum an musikalischen Details aus deiner Performance bei einer perfekten Studio-Aufnahme herausholt.

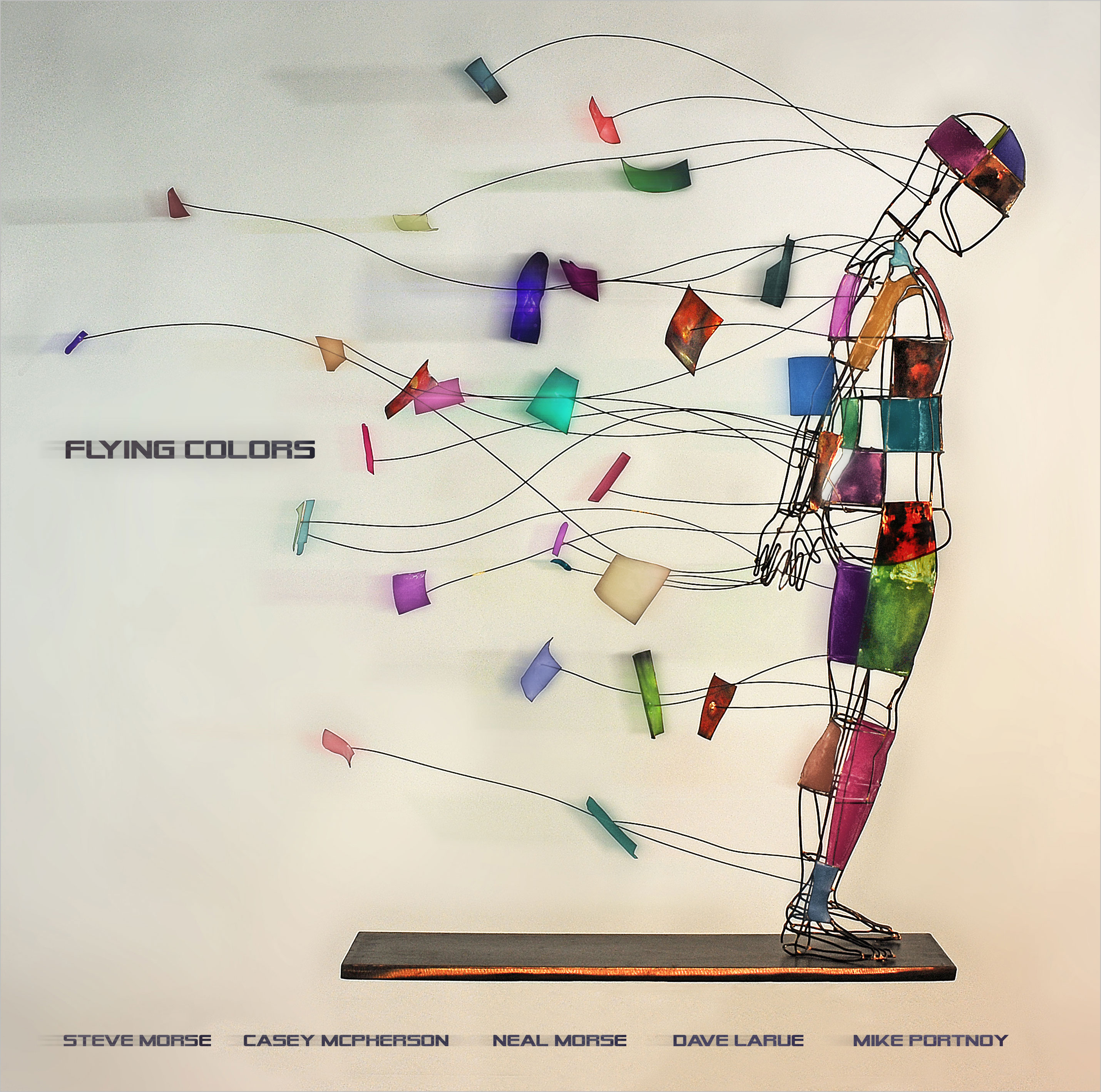

Seitdem ich diese Techniken 2015 etabliert habe, arbeite ich an Aufnahmen mit Künstlern wie Albert Lee, Mike Portnoy, Dave LaRue, Neal Morse, Steve Lukather, Sterling Ball, Steve Vai, Marco Minnemann, John Wesley, John Petrucci and Jay Graydon. Mit der Gruppe Flying Colors arbeite ich am engsten zusammen (Steve Morse, Dave LaRue, Casey McPherson, Neal Morse und Mike Portnoy).

Welches Projekt hat dir am meisten Spaß gemacht und welches war die anspruchvollste?

Nachdem ich die Harmonic Phrase Analysis & Restoration (HPAR) entwickelt habe, absolvierte ich 2001 meinen Hochschulabschluss und fing an mit Kerry Livgren zusammenzuarbeiten. Ich startete bei seinem Webmaster und beteiligte mich an einer Vielzahl an Projekten wie zum Beispiel das Management seiner Zweit-Band Proto-Kaw. (Ich glaube, dass meine wiederholten Versuche rückwärts in seine Einfahrt einzuparken, ihn am meisten belustig haben). All diese Projekte, waren sehr spaßig. Kerry ist ein herausragender Künstler, Lehrer und Freund.

Das anspruchvollste Projekt bisher, war das Album, bei dem HPAR zum ersten Mal genutzt wurde: Flying Colors‘ „Second Flight: Live at the Z7“. Die Band besteht aus Virtuosen und unglaublich ausdrucksstarken Sängern. My Hauptziel war es, eine Klarheit zu präsentieren, die so noch nie bei eine Live-Aufnahme erlebbar war. Ich hatte das Glück mit meinem Assistenz-Engineer Tom Price zu arbeiten, der von unschätzbarem Wert während des Prozesses war. Mixing-Engineer Rich Mouser war die zentrale Ansprechperson, als es darum ging, die Klänge zum Leben zu erwecken. Es war wirkliche Team-Arbeit.

Wie gehst du mit der Problematik um, dass die Spielfehler eines Musikers auf der Live-Aufnahme gesehen werden können, die Korrektur jedoch nicht mehr dem visuell Gespieltem entspricht? Zum Beispiel dann, wenn das Bildmaterial so gut ist, dass die wichtige Passage mit dem Fehler, nicht ersetzt werden kann.

Das ist eine sehr gute Frage! Typischerweise kannst du es wegschneiden oder eine Weitaufnahme verwenden. Ein Hauptgrund dafür ist, dass die gängigste Lösung für Performance-Fehler, das Re-Recording ist. Es ist kein Geheimnis, dass große Passagen von vielen (oder den meisten) kommerziellen Live-Releases, re-recordet werden. Manchmal wird dies einfach angewendet, um die Klarheit zu verbessern – unabhängig von der Performance. Wenn es aber um Solos und Gesang geht, ist es unmöglich das ursprüngliche Timing und dessen Artikulation zu replizieren (welche auch gesehen werden kann).

Einer der Entdeckungen, die aus meiner Recherche hervorging, war folgendes:

Auf der kognitiven Ebene bildet das Gehirn – bevor der Performer seine Hand bewegt – ein detailliertes motorisches Programm ab, welches definiert wie die zähligen Muskeln im Körper zusammen funktionieren, um eine Aktion auszuführen (z.B. eine Gitarren-Saite anschlagen). Eine gespielte Gitarren-Note kann das Ergebnis hunderter minutiös getimter Muskelbewegungen sein, von denen der Performer sich nicht einmal im Klaren ist. Wenn auch nur eins dieser Bewegungen schief geht, kann das in einen hörbaren Fehler resultieren, obwohl die meisten Körperbewegungen korrekt ausgeführt wurden. Wenn ein Part im Studio re-recorded wird, können die exakten Bewegungen nicht wiederholt werden. Es kann somit nur versucht werden, sich dem zuvor Gespielten anzunähern. So muss also diese eine Videoaufnahme entfernt werden, sobald das Re-Recording über den Videoabschnitt kopiert wird, auf dem der Künstler seine ursprünglichen Bewegungen On-Stage ausführt.

Mit der Performance Restauration versuchen wir präsize das Ergebnis des ursprünglichen motorischen Programms des Performers wiederherzustellen. Deswegen sieht es bei der Betrachtung des originalen Footages so aus, als würde der Künstler die Sounds kreieren, die er im Sinn hatte während gleichzeitig seine Bewegungen dazu passen.

Irgendwo auf dem Videomaterial, kann der ursprüngliche motorische Programmfehler gesehen werden. Vergiss aber nicht, dass Musik nur in unserem Verstand stattfindet und viele der unbewussten kognitiven Prozesse die Erfahrungen bilden, die wir als Musik erleben. Ebenso ist das, war wir sehen, ein Produkt visueller Verarbeitung in unserem Gehirn. Bilder werden dort durch Heuristik verändert und vieles war wir „sehen“ ist eigentlich eine Spiegel dessen was wir über das Gesehene „fühlen“.

Studien haben gezeigt, dass rein durch das Beobachten von Bewegungen (resultierend aus dem motorischen Progamm), der Zuschauer einen hohen Anteil davon erkennen kann, was der Künstler umsetzen möchte. Wenn die produzierte Akustik (nach HPAR) dicht genug den Bewegungen des Künstlers entspricht, wird unser Gehirn die Stellen entfernen, die nicht zum auditiven Reiz passen. Wir bemerken also nie, wenn es dort eine kleine Muskelbewegung gibt, die nicht dem Gehörten entspricht. Alles gleicht und passt sich an.

Man könnte sagen, dass auch Fehler den Geist bzw. den Moment der Performance widerspiegeln. Wo ziehst du also die musikethik-philosopische Grenze was die Korrektur von Live-Aufnahmen angeht und wie definierst du den Spagat zwischen Korrektur und Authentizitätsanspruch?

Spannende Frage! Ich versuche nicht wirklich Fehler zu korrigieren. Ich denke nicht, dass es möglich oder insgesamt wünschenswert ist. Der einzige Weg einen Fehler zu beheben, ist zurück in der Zeit zu gehen. Uns bisher hat iZotope kein Plug-In dafür.

Wir können die Frage eingrenzen, indem wir schauen was passiert, wenn ein Künstler einen Fehler macht. Um exakt zu sein, schauen wir auf ein improvisiertes Solo, weil dort das Meiste schief gehen kann. Zunächst wird der Performer eine hierarchische musikalische Struktur in seinem Kopf bilden; du kannst dir das Solo als Baum mit Zweigen vorstellen und die Blätter sind die Noten. Das Gehirn sendet dann diese Hierarchie weiter zurück in den Verstand, um ein hierarchisches motorisches Kontrollprogramm zu erstellen. Wenn wir bei der Baum-Analogie bleiben, sind die Blätter die sich zu bewegenden Muskeln. Der Großteil des Prozesses ist unbewusst – er muss es sein. Unser bewusster Verstand hat eine sehr limierte Kapazität von acht Dingen, die er sich gleichzeitig merken kann.

Der Fehler kann entweder bei der Konstruktion des musikalischen oder motorischen Kontrollprogramms vorkommen oder bei dessen Initialisierung. Er kann auch vom Bewusstsein während des Ausführungsprozesses geschehen. Zum Beispiel, wenn jemand bei einem Konzert denkt, dass der Blitz das Bild verbessern wird, es jedoch kurzzeitig den Performer erblinden lässt.

Was ich mit HPAR versuche, ist Zeit zu überlisten. Ich kann die Vergangenheit nicht ändern, aber ich kann hervorheben, was passiert ist, als die Performance geschah, um das hier und jetzt abzubilden und die Zukunft zu verändern. Wenn ich Bruchteile des ursprünglich musikalischen und motorischen Programms wiederherstellen kann, habe ich Puzzleteile, welche die ursprünglich angedachte Performance restaurieren können. Ich kann voraussagen wie es geklungen hätte, um dann auf diese Sounds hin zuarbeiten.

Nach meiner Auffasung, ist das der authentischste Weg mit Performance-Fehlern umzugehen, weil ich an keinem Punkt etwas „fixe“, was der Künstler tat. Stattdessen rolle ich den Zeitstrang aus, um die ursprüngliche Intention des Performers zu determinieren und zu restaurieren. Wenn ich das erfolgreich schaffe, habe ich nichts „gefixt“ (im üblichen Sinne des Wortes).

Nächster Beitrag >

Artist Interview: Brisk Fingaz

< Vorheriger Beitrag

Artist Interview: Heba Kadry

Diese Artikel könnten Sie auch interessieren

Bombay Bicycle Club Frontmann Jack Steadman im Interview.

Das Magix Interview mit Jack Steadman, Sänger, Gitarrist, Pianist, Producer, dem Frontmann der britischen Indie Rock Band Bombay Bicycle Club.

Filmmusiker Bob Humid im Interview

Seit 20 Jahren ist Bob im Bereich des Sound Designs aktiv. Im Interview teilte er mit uns seine Erfahrungen mit Samplitude und Sequoia.

Von Music Maker zu Samplitude Music Studio

Music Maker Vorkenntnisse nutzen und auf Samplitude Music Studio anwenden. Wir erklären, warum das Upgrade sich lohnt!

SOUND FORGE Artist Feature: Live Sets Chicago

Live Sets Chicago dokumentiert DJ-Sets von Künstlern wie Mark Farina, Sander Kleinenberg mithilfe der SOUND FORGE Pro Mac-Software.